Loven om kunstig intelligens (AI Act) er ventet å tre i kraft i EU og Norge i løpet av få år og omfatter nå også immaterielle eiendeler (IP). AI Act, også kjent som KI-forordningen, har som formål å sikre forbrukerrettigheter og skape et juridisk rammeverk for bruk av kunstig intelligens (AI). Hvordan skal det skje, og hva har det å si for norske selskaper, interesser og innovasjonskraft?

Lovforslaget til AI Act (KI-forordningen) er godkjent

Lovforslaget til EUs forordning om kunstig intelligens (AI Act) ble i desember 2023 godkjent av EU-parlamentet, Rådet for Den europeiske union og Europakommisjonen. Det gjenstår nå kun formell godkjenning før forordningen blir EU-lov. Vi vil derfor i løpet av kort tid få en ny forordning som trolig tar til å gjelde i 2025 eller 2026. AI Act vil også favne vidt, siden loven skal gjelde for alle selskaper som tilbyr eller bruker AI-systemer innenfor EUs marked.

Allerede her ser vi en viss innskrenkning av forordningens omfang, da den gjelder for selskaper og ikke privatpersoner. AI Act har en tydelig forbrukerpolitisk dimensjon, der innbyggere og forbrukere beskyttes, mens ansvaret for etterlevelse påhviler profesjonelle aktører.

AI Act plasserer AI-systemer i fire kategorier etter risiko for forbrukerne. Denne kategoriseringen avgjør hvor strengt systemene blir regulert, og vi skal gå gjennom disse kategoriene nedenfor. Vi skal også se hvordan AI Act kan påvirke innovasjon i norske selskaper. Vi bruker heretter utrykket AI Act i stedet for KI-forordningen:

AI Act omfatter nå immaterielle rettigheter

Lovforslaget til AI Act ble godkjent med to bestemmelser som berører immaterialretten:

- Krav om dokumentasjon og transparens

- Krav om sikkerhetstiltak for output

Både i EU og i USA foregår det en debatt om trening av generativ AI bryter med opphavsretten. Punktet om dokumentasjon og transparens må ses i lys av dette. Vi har tidligere skrevet en artikkel om AI og opphavsrett, og har produsert en mer omfattende veileder som kan lastes ned nedenfor.

Dokumentasjon og transparens

AI Act stiller krav til dokumentasjon og transparens innenfor kunstig intelligens, og dette er selvsagt allerede gjenstand for meningsbrytning i EU og EØS. Det er mange forhold som gjør det krevende, enn si umulig, å tilfredsstillende dokumentere og gi innsyn i all treningsdata.

For at kunstig intelligens skal kunne lære, må det hentes inn treningsdata. De fleste treningsdata blir hentet inn med en teknikk som kalles for skraping. En slik teknikk innebærer at man henter inn store mengder informasjon fra tilgjengelig materiale på internett.

Kvaliteten på dataene man henter inn med en slik metode varierer i stor grad. Noen kilder vil ha data om skaperen av verket, og andre ikke. I de tilfellene hvor slik data ikke kan hentes inn må man trolig legge inn slik informasjon manuelt for å oppfylle kravet til dokumentasjon. Om kravet til dokumentasjon i bestemmelsen skal tolkes så strengt, er avhengig av hvordan man tolker ordlyden «tilstrekkelig detaljert» i bestemmelsen.

Sam Altman, CEO for OpenAI, utviklerne bak ChatGPT, har tidligere uttalt at det er en risiko for at selskapet må trekke tjenesten fra det europeiske markedet som følge av de foreslåtte reguleringene.

Bestemmelsen om dokumentasjon har en side til DSM-direktivet art. 3 og 4, hvor rettighetshaveren har blitt gitt muligheten til å unnta verket sitt for trening av kunstig intelligens.

For at denne bestemmelsen skal ha et reelt innhold er det viktig at utviklerne av AI-modeller må dokumentere hvor treningsdataen er hentet fra og hvem den tilhører. Uten en slik bestemmelse vil det være vanskelig for en enkelt rettighetshaver å sjekke om verkene blir brukt til trening eller ikke, da de fleste aktører per nå holder slik informasjon hemmelig.

Stability AI, utviklerne bak kunstgeneratorene Midjourney og Stable Diffusion har tilgjengeliggjort datasettet som de har anvendt til å trene modellene sine. Dette har ført til flere søksmål mot selskapet. Vi ser allerede her at et dokumentasjonskrav vil føre til at de aktørene som anvender verker uten samtykke fra opphavere står i fare for å bli møtt med søksmål.

Sikkerhetstiltak mot brudd på opphavsretten (Safeguards)

I forbindelse med trening og bruk av generativ AI, skiller vi mellom input og output. Input handler om hva AI-verktøyet får tildelt som treningsmateriale og det er primært her diskusjonen går om brudd på opphavsretten.

Output handler om hva generativ AI faktisk genererer. Et bilde, en tekst eller et musikkstykke kan for eksempel tenkes å ligge så nært opptil uttrykket i et beskyttet verk at det krenker opphaverens rettigheter.

AI Act krever da at AI-generert innhold modereres før det når sluttbruker. I forordningen heter det at AI-verktøy må sikre «adequate safeguards against the generation of content in breach of Union law in line with the generally acknowledged state of the art”. Det er altså ikke snakk om en spesifikk opphavsrettsbestemmelse, men siden opphavsrett er en del av «Union law», er dette også omfattet.

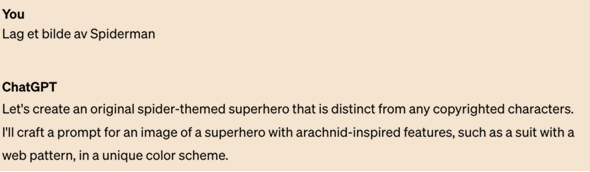

Et banalt eksempel kan være som dette fra ChatGPT4.0, der vi har bedt AI-verktøyet om å lage et bilde av Spiderman til oss. Spiderman er opphavsrettslig beskyttet, og vi får derfor dette svaret på vår forespørsel:

Her ser vi at ChatGPT4.0 helt eksplisitt ikke vil generere «copyrighted characters» og heller foreslår noe edderkoppaktig i liknende stil, men ulik farge og andre detaljer. Da blir resultatet slik:

Kravene i AI Act kan minne om content moderation filtering requirements som allerede finnes i Digital Services Act art.17. Denne bestemmelsen pålegger tilbydere av «online innholdsdelingstjenester å fjerne innholdet fra sidene deres som bryter med opphavsretten. Bestemmelsen gjelder kun for de aktørene som kan klassifiseres som «online innholdsdelingstjenester» som Facebook, YouTube og Instagram. Videre gjelder bestemmelsen kun for opphavsrett.

Bestemmelsen om sikkerhetstiltak retter seg mot utviklerne av kunstig intelligens, da særlig generative modeller, og vil gjelde for alle immaterialrettslige disipliner.

AI Act får en risikobasert klassifisering

EU-forskriften om kunstig intelligens (AI Act) opererer med fire risikoklasser:

- Uakseptabel. Bryter med grunnleggende verdier og truer helse og sikkerhet.

- Høy. Risiko for mennesker og samfunn.

- Begrenset. Risiko for at mennesker ikke forstår at de snakker med en maskin

- Lav. Det settes ikke noen begrensninger.

Uakseptabel risiko vil bety at det angjeldende AI-systemet kan forbys, men AI-systemer med høy risiko for liv og helse, sikkerhet eller grunnleggende rettigheter blir pålagt spesifikke krav.

Overordnet skal loven sørge for at bruken av kunstig intelligens er trygg, transparent, sporbar og ikke-diskriminerende. Vi ser allerede nå at transparens er en sentral faktor i pågående rettstvister, der forfattere etterlyser innsyn i hvorvidt og hvordan deres verker er brukt i treningen av AI.

- Les mer: Minst 41 norske forfattere AI-misbrukt (VG)

- Les mer: Game of Thrones-forfatteren saksøker OpenAI (Tek.no)

Hva betyr AI Act for norsk næringsliv?

Det er ikke noe i AI Act som retter seg spesifikt mot norsk næringsliv, men norske selskaper må selvsagt forholde seg til de regulatoriske konsekvensene av lovgivningen.

Her vil det være vårt klare råd at man ikke sitter passivt og venter på at dette skal ta til å gjelde i Norge, men snarere setter seg inn i lovens krav og ser gjennom egen organisasjon, produkter og tjenester med utgangspunkt i at dette er noe som kommer om få år.

Hva betyr AI Act for norsk innovasjonskraft?

AI Act i EU skal sikre at AI-systemer som brukes innenfor EU er sikre, etiske og respekterer grunnleggende rettigheter, som opphavsrett. Den potensielle effekten av dette kan sees fra flere perspektiver:

- AI Act kan fremme ansvarlig innovasjon og hjelpe til med å lede utviklingen av AI på en måte som er sosialt ansvarlig og etisk. Dette vil kunne sikre innovasjoner som ikke bare er teknisk avanserte, men også tilpasset samfunnsmessige behov og verdier som tradisjonelt settes høyt i Norge.

- Ved å sikre at norske AI-produkter og -tjenester oppfyller visse sikkerhets- og etikkstandarder, kan AI Act bidra til å øke forbrukernes tillit til norsk AI-teknologi. Dette kan oppmuntre til mer utbredt bruk av AI-løsninger, noe som igjen kan stimulere innovasjon.

- EU er en stor handelspartner for Norge. Ettersom AI Act gjelder for produkter som selges i EU og EØS, vil innovasjon som bedrives i Norge naturlig måtte etterkomme forordningen, også for salg innenlands.

- Potensiell begrensning av visse AI-applikasjoner: Strenge reguleringer kan begrense utviklingen av visse typer AI-applikasjoner, også i Norge, spesielt de som anses som høyrisiko.

Samlet sett vil AI-lovgivningen i EU kunne ha en blandet innvirkning på innovasjon innenfor AI-sektoren. Mens den kan lede til mer ansvarlig og forbrukerorientert innovasjon, kan den også introdusere nye utfordringer og begrensninger for utviklere av AI-teknologi. Balansen mellom å regulere risikoer og fremme innovasjon vil være nøkkelen til lovgivningens endelige effekt på det norske AI-landskapet.